Tips sobre la administración de Linux

Tips recogidos a lo largo de mi vida, que al no ser mucho uso, se van olvidando.

- Administración de usuarios

- Como eliminar kernels antiguos

- Seguridad, SSl, etc.

- Verificar versiones y ciphers soportados de TLS, SSL

- CSF error: *WARING* URLGET set to use LWP but perl module is not installed, fallback to using CURL/WGET

- Limitar en el tiempo (expirar en una fecha) una llave openSSH en el authorized_keys

- Comprobar una conexión SMTP autentificada en el shell con SSL o TLS

- CSF Firewall: añadir IPs al deny de forma definitiva.

- Certificados Letsencrypt sin servidor web o sin resolver en el servidor web

- Cambio de hostname permanentemente

- Hardware

- Conocer el hardware en linea de comandos (shell)

- Uso de UUID para montar particiones linux

- Instalación GPT con el instalador Centos 7 en discos < 2 TiB

- Parted mejor que fdisk

- Directadmin

- MySQL - MariaDb

- ERROR 1118 (42000) at line XXXXX: Row size too large (> 8126)

- Errores con MariaDB 10.3 al restaurar o hacer backups arrastrando versiones antiguas

- Como extraer de un backup de MySQL completo una base de datos y/o una tabla

- Como crear un usuario Mysql/MariaDB con Grant Privileges

- Restaurar mysqldump completo con problemas relacionados con VIEW y sus permisos

- Desactivación de las reglas de modos SQL de un sevidor MySQL/MariaDB/Percona

- ISPConfig

- Backups

- Rsync sobre sistemas remotos

- rsync-time-backup: include y exclude

- Diagnóstico y resolución de fallos en snapshots LVM durante backups en Proxmox

- Tips and Tricks

- Como convertir ficheros .flac a .mp3 en el shell de linux con ffmpeg

- Teclas Inicio (Home) y Final (End) en ZSH y oh-my-zsh con Powershell

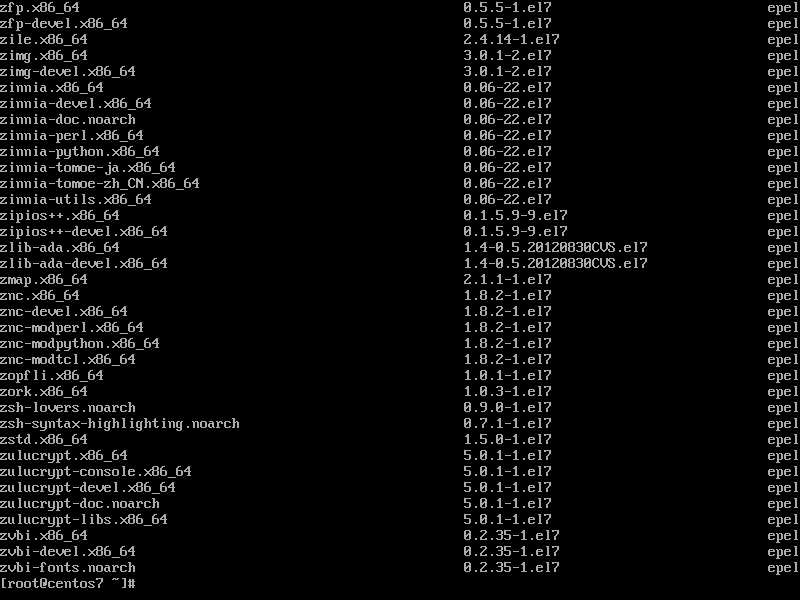

- Linux, paquetes instalados desde el shell

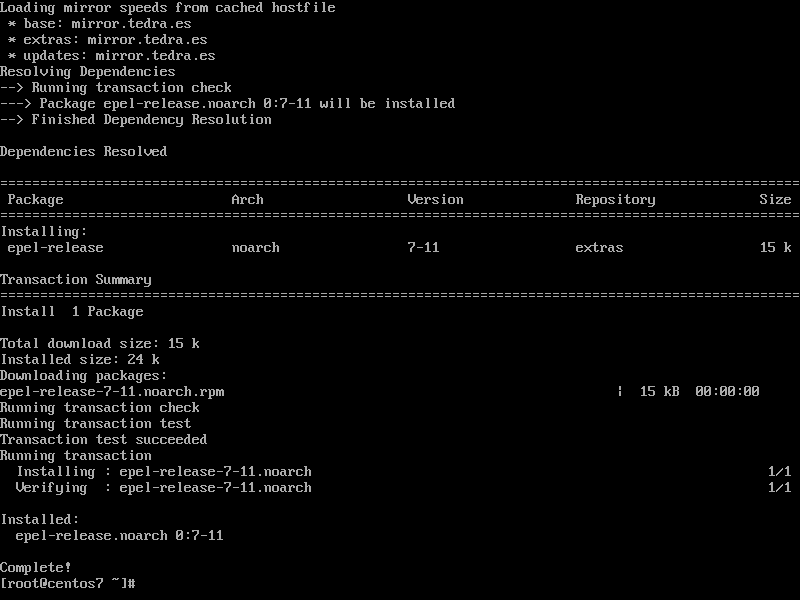

- Cómo instalar y activar el repositorio EPEL en Centos 7/8

- Conocer el tamaño de unas carpetas ignorando los enlaces duros (rsync)

- Ssh se sale (break) de un ciclo (loop) en un script bash

- Redis Failed to start Advanced key-value store.

- Comando find con -maxdepth excluyendo el propio directorio

- Du y los ficheros o directorios ocultos

- Como vaciar o eliminar emails antiguos en dovecot sin usar find

- rc.local en systemas Debian usando systemd. Ejemplo redis

- Bad Bots y la pesadilla del tráfico. Htaccess en Apache 2.4

- Sudo sin contraseña

- Reparar el fichero .zsh_history: zsh: corrupt history file /home/USER/.zsh_history

- El archivo hosts para trabajar en un servidor o ip distinto del de la resolución DNS

- Cambiar repositorios de Ubuntu al mirror de OVH

- ## Guía Rápida de find - Búsquedas Avanzadas

- APT Upgrade - Modos Desatendido vs Manual

- Crear una unidad lógica con el 100%

- Búsqueda y reemplazo recursivo con sed en directorios

- Instalación de Node.js LTS 22 y npm en Ubuntu con CloudLinux CageFS

- PHP

- PHP log cuando usamos PHP-FPM con host virtuales

- PHP. Como instalar una nueva versión de PHP en un sistema basado DEB

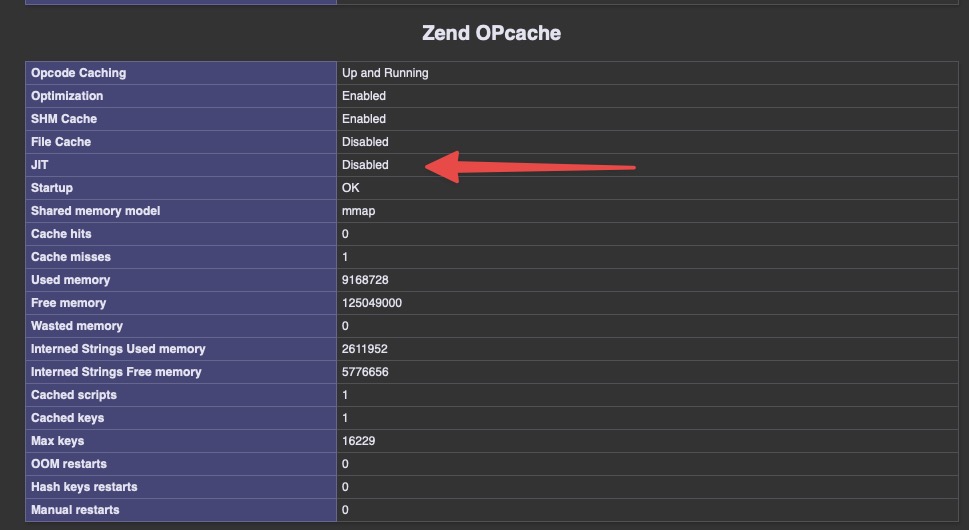

- Activar PHP8.2 JIT Compiler - Just-In-Time compilation (JIT)

- Instalar una versión de PHP con módulos en Ubuntu con Ondrej copiando de otra versión ya instalada

- Proxmox

- Git pull, error: server certificate verification failed. CAfile: none CRLfile: none

- [PRIV] Instalar Proxmox desde 0

- LVM Práctico para Proxmox y OVH

- Red OVH vrack para Proxmox 7

- Como arreglar el error Sender address rejected: need fully-qualified address (in reply to RCPT TO command)

- Proxmox, Hetzner, y bloques de Ips adicionales en modo Routed

- Desactivar los mensajes de log en la consola (Proxmox)

- Proxmox: Servicios Colgados - Diagnóstico y Soluciones

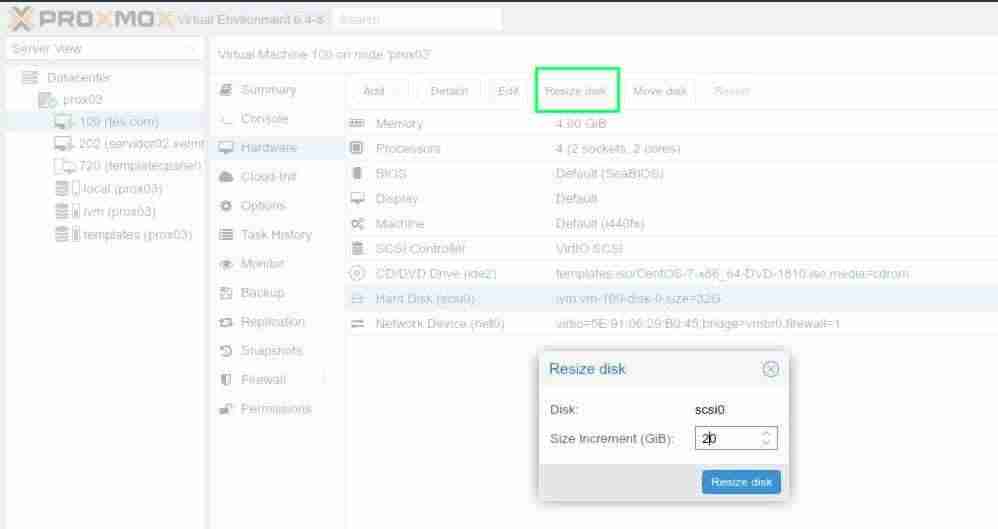

- Ampliación de disco (basado en qcow2) en sistema virtualizado KVM (proxmox)

- Ampliación de disco en sistema virtualizado KVM (proxmox)

- NFS cliente en un sistema linux (rpm o debian)

- SSH

- Unable to negotiate with X.X.X.X.X port YY: no matching host key type found. Their offer: ssh-rsa,ssh-dss

- PasswordAuthentication yes pero no funciona

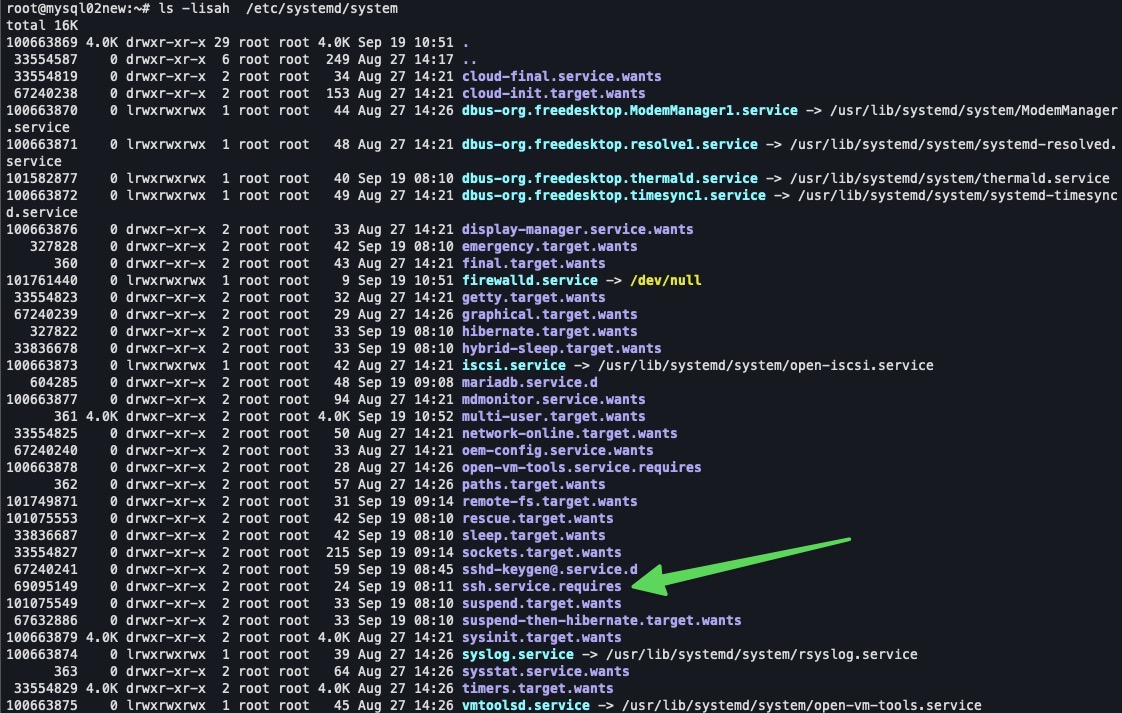

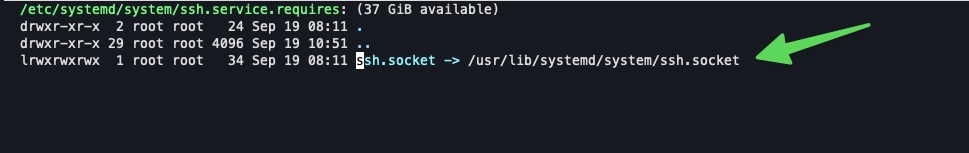

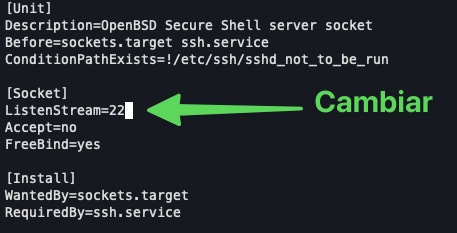

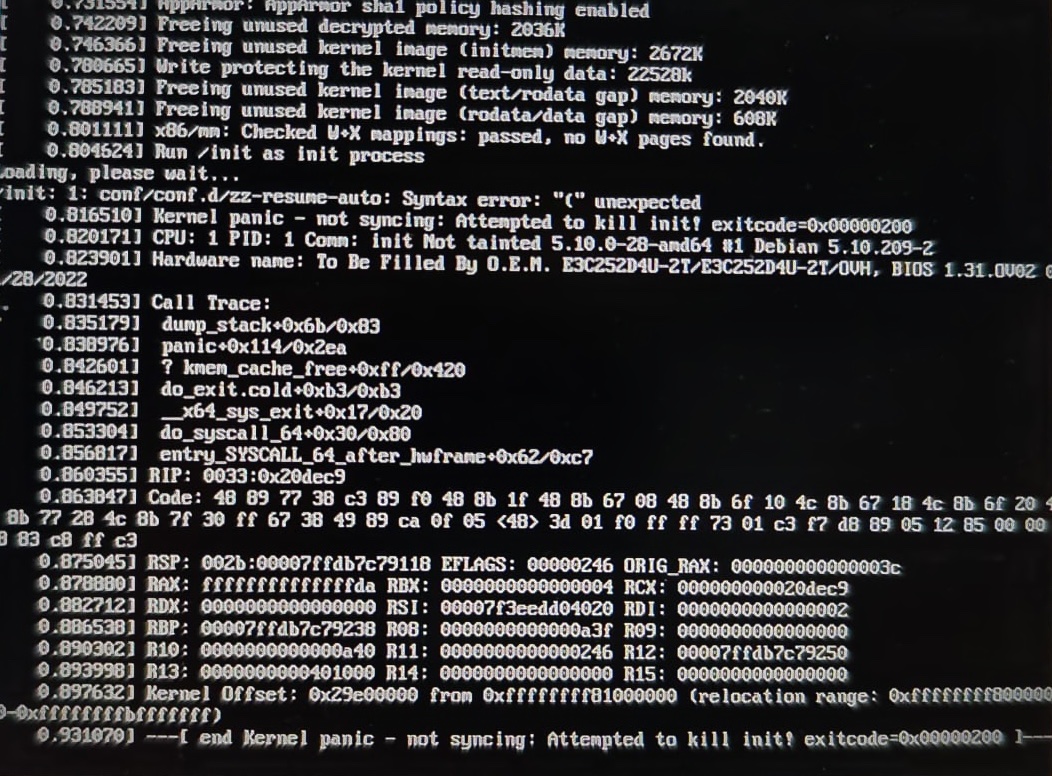

- Cambiar el puerto SSH en Ubuntu 24.04 y Debian Bookworm

- Apagando fuegos

- your CPU is missing AVX instruction set flag para instalar mongoDb Jetbackup entre otros

- Nginx

- Gestión de Versiones de PHP en Raspberry Pi

- Configuración correcta de Let's Encrypt en Webmin con

- Cosas de relays y postfix

- Zabbix

- Mysql-MariaDB

Administración de usuarios

Administrar usuarios y grupos

Cambiar el username en linux

Cambiar el username o nombre de usuario

Muchas veces nos encontramos con situaciones en las que heredamos un sistema con usuarios, cuyo nombre queremos normalizar con nuestra infraestructura.

En un sistema Linux, sin panel de control, es una operación sencilla siempre que no exista ningún proceso del usuario ejecutandose.

sudo usermod -l nuevoNombreDeUsuario antiguoNombreDeUsuarioPero este comando solo cambiara el nombre del usuario, sin cambiar el nombre de su home.

Para cambiar el nombre del home del usuario ejecutaremos el código de abajo, después de haber ejecutado el anterior:

sudo usermod -d /home/nuevoHomeDir -m nuevoNombreDeUsuarioExplicación

Los sistemas Unix desacoplan el nombre de usuario de la identidad del usuario, por lo que es seguro cambiar el nombre del usuario sin afectar al ID. Todos los permisos, archivos, están vinculados a su identidad (uid), no a su nombre de usuario.

Para administrar todos los aspectos de la base de datos de usuarios, se utiliza la herramienta, usermod.

Tips

Algunos ficheros o programas pueden tener referencias absolutas a su antiguo directorio, por lo que se aconseja crear un enlace simbólico como forma de compatibilidad hacia atrás.

ln -s /home/nuevoNombre /home/viejoNombreAdvertencias

No usar con paneles de hosting, como cPanel, Directadmin, Plesk, porque el desastre puede ser mayúsculo. En su lugar tratar de localizar la documentación de ellos, y leer en sus foros, pues algunas veces sus propias herramientas pueden darte un buen disgusto.

Atención especial si el sistema esta encriptado. No he probado jamas este tip en esa situación.

Enlaces

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como esta, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

Como eliminar kernels antiguos

Introducción

Algunas distribuciones suelen hacer una instalación por defecto con la particion /boot o incluso a nosotros nos guste hacerlo asi. Pero se el tamaño suele ser exiguo y con el paso del tiempo los kernels han ido cogiendo tamaño y nos podemos quedar con el espacio justo o incluso hacer un update que del kernel que falle por no poder grabarse el archivo de arranque.

Mejor dejarlo en lo justo.

Centos

Centos 7.X

Listado de kernels instalados

[root@fail401 ~]# rpm -q kernel

kernel-3.10.0-1160.11.1.el7.x86_64

kernel-3.10.0-1160.15.2.el7.x86_64

kernel-3.10.0-1160.21.1.el7.x86_64

kernel-3.10.0-1160.24.1.el7.x86_64

kernel-3.10.0-1160.25.1.el7.x86_64

Kernel en ejecución

[root@fail401 ~]# uname -a

Linux fail401.xxxxx.com 3.10.0-1160.15.2.el7.x86_64 #1 SMP Wed Feb 3 15:06:38 UTC 2021 x86_64 x86_64 x86_64 GNU/Linux

Método con el comando package-cleanup

Este comnado esta dentro dle paquete yum-utils

[root@fail401 ~]# package-cleanup --oldkernels --count=2

Complementos cargados:fastestmirror

--> Ejecutando prueba de transacción

---> Paquete kernel.x86_64 0:3.10.0-1160.11.1.el7 debe ser eliminado

---> Paquete kernel.x86_64 0:3.10.0-1160.15.2.el7 debe ser eliminado

---> Paquete kernel.x86_64 0:3.10.0-1160.21.1.el7 debe ser eliminado

--> Resolución de dependencias finalizada

Dependencias resueltas

=============================================================================================

Package Arquitectura Versión Repositorio Tamaño

=============================================================================================

Eliminando:

kernel x86_64 3.10.0-1160.11.1.el7 @updates 64 M

kernel x86_64 3.10.0-1160.15.2.el7 @updates 64 M

kernel x86_64 3.10.0-1160.21.1.el7 @updates 64 M

Resumen de la transacción

=============================================================================================

Eliminar 3 Paquetes

Tamaño instalado: 193 M

Está de acuerdo [s/N]:s

Downloading packages:

Running transaction check

Running transaction test

Transaction test succeeded

Running transaction

Eliminando : kernel.x86_64 1/3

Eliminando : kernel.x86_64 2/3

Eliminando : kernel.x86_64 3/3

Comprobando : kernel-3.10.0-1160.15.2.el7.x86_64 1/3

Comprobando : kernel-3.10.0-1160.11.1.el7.x86_64 2/3

Comprobando : kernel-3.10.0-1160.21.1.el7.x86_64 3/3

Eliminado(s):

kernel.x86_64 0:3.10.0-1160.11.1.el7 kernel.x86_64 0:3.10.0-1160.15.2.el7

kernel.x86_64 0:3.10.0-1160.21.1.el7

¡Listo!

Versión manual

Tendremos que usar el comando rpm -e

[root@fail401 ~]# rpm -e kernel-3.10.0-1160.11.1.el7.x86_64 kernel-3.1X.X0-XXXXX.XX.X.el7.x86_64 ...

Ubuntu

¿Cómo concoer la lista de kernels de linux instalados?

sudo dpkg --list | egrep -i --color 'linux-image|linux-headers'

Ubuntu Focal 20.04

sudo apt --purge autoremove

sudo apt-get --purge autoremove

Agrdecimientos y enlaces

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

Seguridad, SSl, etc.

Todos sobre seguridad, certificados, comprobación de ciphers

Verificar versiones y ciphers soportados de TLS, SSL

Introducción

Una de los mayores problemas al que se enfrenta el soporte es lidiar con los clientes y los problemas derivados del uso de sistemas (windows, MacOSX, Ios, Android, ...) obsoletos.

Verificar TLS soportado por un protocolo

h=nombre_del_host

p=port

## Tls 1.2

openssl s_client -connect $h:$p -tls1_2

### Tls 1.1

openssl s_client -connect $h:$p -tls1_1

### Tls 1

openssl s_client -connect $h:$p -tls1

El retorno debe tener una linea como esta

Verification: OK

Enumerar los ciphers ssl

h=nombre_del_host

p=port

nmap --script ssl-enum-ciphers -p $p $h

Starting Nmap 7.80 ( https://nmap.org ) at 2021-05-15 17:43 CEST

Nmap scan report for kvm468.ceinor.com (5.135.93.99)

Host is up (0.056s latency).

PORT STATE SERVICE

465/tcp open smtps

| ssl-enum-ciphers:

| TLSv1.2:

| ciphers:

| TLS_DHE_RSA_WITH_AES_128_GCM_SHA256 (dh 2048) - A

| TLS_DHE_RSA_WITH_AES_256_GCM_SHA384 (dh 2048) - A

| TLS_ECDHE_RSA_WITH_AES_128_GCM_SHA256 (secp256r1) - A

| TLS_ECDHE_RSA_WITH_AES_256_GCM_SHA384 (secp256r1) - A

| compressors:

| NULL

| cipher preference: client

|_ least strength: A

Nmap done: 1 IP address (1 host up) scanned in 2.81 seconds

Links y agradecimientos

- Command prompt to check TLS version requiere by a host

- Checking ssl tls Version Support of a Remnote Host from Command line

CSF error: *WARING* URLGET set to use LWP but perl module is not installed, fallback to using CURL/WGET

Introducción

Casi siempre que se instala CSF Firewall en una distribución linux tenemos el mismo problema relativo a la ausencia de las librerías de perl LWP requeridas por CSF o mejor dicho preferidas ya que el propio CSF nos ofrece 3 posibilidades de configuración para la descarga de listas u otros elementos desde sitios remotos vía HTTPS.

- HTTP::Tiny

- LWP::UserAgent

- CURL/WGET (set location at the bottom of csf.conf)

LWP::UserAgent

Es la opción deseada y configurada por CSF, y esta configuración al no encontrar disponible el binario correspondiente, te lanza la advertencia cada vez que ejecutes un comando de csf.

*WARNING* URLGET set to use LWP but perl module is not installed, fallback to using CURL/WGET

Realmente en su propio fichero de configuración se encuentra el cómo, pero si has llegado hasta aquí, es que no lo leiste. (Es lo normal. No solemos leer los LEAME.txt vamos a leer los cientos de comentarios de algunos ficheros de configuración)

Distribuciones basada en RPM (Centos, AlmaLinux, CloudLinux,..)

yum install perl-libwww-perl.noarch perl-LWP-Protocol-https.noarch

Distribuciones basadas en APT (Debian, Ubuntu,...)

apt-get install libwww-perl liblwp-protocol-https-perl libgd-graph-perl

Via cpan

# perl -MCPAN -eshell

cpan> install LWP LWP::Protocol::https

Documentación original CSF (ConfigServer Firewall)

# The following option can be used to select the method csf will use to

# retrieve URL data and files

#

# This can be set to use:

#

# 1. Perl module HTTP::Tiny

# 2. Perl module LWP::UserAgent

# 3. CURL/WGET (set location at the bottom of csf.conf if installed)

#

# HTTP::Tiny is much faster than LWP::UserAgent and is included in the csf

# distribution. LWP::UserAgent may have to be installed manually, but it can

# better support https:// URL's which also needs the LWP::Protocol::https perl

# module

#

# CURL/WGET uses the system binaries if installed but does not always provide

# good feedback when it fails. The script will first look for CURL, if that

# does not exist at the configured location it will then look for WGET

#

# Additionally, 1 or 2 are used and the retrieval fails, then if either CURL or

# WGET are available, an additional attempt will be using CURL/WGET. This is

# useful if the perl distribution has outdated modules that do not support

# modern SSL/TLS implementations

#

# To install the LWP perl modules required:

#

# On rpm based systems:

#

# yum install perl-libwww-perl.noarch perl-LWP-Protocol-https.noarch

#

# On APT based systems:

#

# apt-get install libwww-perl liblwp-protocol-https-perl

#

# Via cpan:

#

# perl -MCPAN -eshell

# cpan> install LWP LWP::Protocol::https

#

# We recommend setting this set to "2" or "3" as upgrades to csf will be

# performed over SSL as well as other URLs used when retrieving external data

#

# "1" = HTTP::Tiny

# "2" = LWP::UserAgent

# "3" = CURL/WGET (set location at the bottom of csf.conf)

URLGET = "2"

# If you need csf/lfd to use a proxy, then you can set this option to the URL

# of the proxy. The proxy provided will be used for both HTTP and HTTPS

# connections

URLPROXY = ""

Aviso Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

Limitar en el tiempo (expirar en una fecha) una llave openSSH en el authorized_keys

Introducción

Un serio handicap en los modelos de administración de sistemas basados en el ser humano, es que un despiste puede ser fatal para nuestra seguridad.

Cuando necesitamos añadir una llave SSH a un servidor para el acceso del propietario de dicha llave, y necesitamos que sea temporal, suele ocurrir, que al final, la llave termina por olvidarse.

Por mi trabajo, muchas veces accedo a servidor en los que tengo que realizar trabajos de auditoría o de tunning, y me encuentro llaves autorizadas desde el principio de los tiempos.

Añadir un limite de tiempo a una llave OpenSSH autorizada

Al igual que podemos limitar los comandos que el propietario de dicha llave SSH pueda hacer en nuestro sistema, también podemos limitar la validez de la llave en el tiempo.

Si nuestro servidor esta ejecutando una version OpenSSH 7.7 o superior, podremos hacerlo añadiendo expiry-time a la entrada de la llave a la que queremos limitar en el tiempo el acceso con el formato expiry-time="YYYYMMDD" ssh-rsa AAAAB3Nz...w== Algun comentario

expiry-time="20210621" ssh-rsa AAAAB3NzaC1yc2.. ...MXhBut9HKkWI9/ root@prox03

También puedes especificar un tiempo más concreto, usando YYYYMMDDhhmm (la versión YYYYMMDD entiende como si fuera la media noche, 2020-06-21 00:00:00

Enlaces

Adding expiration date to SSH key

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

Comprobar una conexión SMTP autentificada en el shell con SSL o TLS

Introducción

Muchas veces el soporte técnico o nosotros, tenemos que comprobar si los datos que tenemos y si el servidor SMTP remoto, están operando correctamente. No es necesario hacer como hacen algunos un cambalache creando una cuenta en el programa de correo electrónico, sino que como casi siempre podemos acudir a nuestra shell para realizar las pruebas pertinentes.

Comprobar la autenticación SMTP y la conexión SSL usando la línea de comandos o shell.

Autenticación SMTP

La autentificación (autenticación) es el mecanismo por el cual un usuario se identifica a sí mismo en un servicio de un servidor. En este caso el servicio es el correo electrónico saliente o SMTP y es necesario para que podamos enviar correo electrónico.

Preparación, prueba y verificación

Para hacer la prueba es necesario tener instalado el paquete openssl de nuestro ordenador.

Crear la cadena de autenticación para una login basado en PLAIN

Generalmente los servidores de correo electrónico, usan como medio de autenticación uno denominado **PLAIN**, que consiste en pasar un texto plano (ASCII) que contiene el par **usuario + contraseña**

Antes de realizar la prueba debemos obtener la cadena de caracteres ASCII que contiene el par usuario_smtp + contraseña.

Usando Bash

En el momento de escribir esto, el tip que tenía en mi entrada original Cómo comprobar la autenticación SMTP SMTP Auth y la conexión con StartTLS en el shell me da error. La verdad es que he comprobado si había un error en mi escritura, y revisado con otros colegas. Así que he optado por no hacer el comando en una línea sino dividirlo en dos que si me funciona

$ echo -ne usuario@servidor.smtp.com | base64

emFiYml4QQDlbnRyYWwuY2FzdHJpcy5jb20=

$ echo -ne 4Mmr8Hop3FsmQvKtb8Ei | base64

NE1tcjVUb3BhRnNtUXZLdGI4RWk=

Ahora conectamos vía openssl

h y p son variables de entorno para poder trabajar más fácilmente

El puerto deberá ser el apropiado a la conexión, en este caso startssl

$ h=servidor.smtp.com

$ p=455

$ openssl s_client -connect $h:$p -starttls smtp

CONNECTED(00000003)

depth=2 C = US, O = Internet Security Research Group, CN = ISRG Root X1

verify return:1

depth=1 C = US, O = Let's Encrypt, CN = R3

verify return:1

depth=0 CN = servidor.smtp.com

verify return:1

---

Certificate chain

0 s:CN = servidor.smtp.com

…

Extended master secret: no

Max Early Data: 0

---

read R BLOCK

Esto ya nos indica que el servidor está activo, escuchando en el puerto solicitado, y admitiendo la conexión vía startssl

Ahora podemos usar EHLO therepara obtener los comandos disponibles

EHLO there

250-servidor.smtp.com

250-PIPELINING

250-SIZE 10240000

250-VRFY

250-ETRN

250-AUTH PLAIN LOGIN

250-ENHANCEDSTATUSCODES

250-8BITMIME

250-DSN

250-SMTPUTF8

250 CHUNKING

O pasar directamente a la autenticación

AUTH LOGIN

334 VXNlcm5hbWU6

emFiYml4QQDlbnRyYWwuY2FzdHJpcy5jb20=

334 UGFzc3dvcmQ6

NE1tcjVUb3BhRnNtUXZLdGI4RWk=

235 2.7.0 Authentication successful

Usando Perl

Si el usuario contiene la @ esta deberá escaparse con la barra invertida (\) de otra manera perl interpretará un arreglo (array) en lugar de una cadena (string)

Con Perl no tengo problemas para hacer lo mismo pero en lugar de usar AUTH LOGIN usar AUTH PLAIN usando la única cadena codifica del par usuario y contraseña

$ perl -MMIME::Base64 -e 'print encode_base64("\000usuario\@servidor.remoto.tld\000PaSsW0rD")'

AHphYmJpeEBjZW50cmFsLkTgqW3RyaXMuY29tADRNbXI1VG9wM0ZzbVF2S3RiOEVp

$ h=servidor.smtp.com

$ p=455

$ openssl s_client -connect $h:$p -starttls smtp

…

---

read R BLOCK

AUTH PLAIN AHphYmJpeEBjZW50cmFsLkTgqW3RyaXMuY29tADRNbXI1VG9wM0ZzbVF2S3RiOEVp

235 2.7.0 Authentication successful

Enlaces relacionados

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

CSF Firewall: añadir IPs al deny de forma definitiva.

Firewall y bloqueo definitivo para indeseables

A veces, trabajando ves que hay algunas IP que pertenecen a alguien, o incluso a un grupo de IP del mismo proveedor, que no para de aparecer en tus logs.

Además, si manda un correo al abuse@ de l proveedor de servicios, se hace el loco y no te contesta.

Pues que mejor que banear la IP de forma definitiva.

CSF Firewall bloqueo permanente

Esta ahí, en los comentarios del /etc/csf/csf.deny, pero es una de los mas desconocidos del CSF.

# Note: If you add the text "do not delete" to the comments of an entry then

# DENY_IP_LIMIT will ignore those entries and not remove them

Maravilloso verdad?

Ya sólo queda banearle desde el shell.

❯ csf -d 179.43.128.0/18 "do not delete - Panama datacenter sin respuesta"

Adding 179.43.128.0/18 to csf.deny and iptables DROP...

csf: IPSET adding [179.43.128.0/18] to set [chain_DENY]

❯ cat /etc/csf/csf.deny | grep 179.43.128

179.43.128.0/18 # do not delete - Panama datacenter sin respuesta - Sat Aug 17 17:47:12 2024

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

Certificados Letsencrypt sin servidor web o sin resolver en el servidor web

Como obtener el certificado Letsencrypt para un dominio que no resuelve aun en una migración o nuevo servidor

Algunas veces es necesario hacer pruebas antes de levantar una migración en un nuevo servidor en producción.

Para ello, deberemos de forma manual, obtener un nuevo certificado basándonos en el desafio llamado challenge en el que solicitaremos el certificado porque tenemos capacidad de administración de la zona DNS. También se conoce como acme-dns-certbot

Requisitos

En este doc presuponemos que:

- Tienes cierto nivel de usuario Linux.

- Que tienes instalado certbot con snap. Si no, acude a las Instrucciones de Cerbot

- Que tienes instalado Python 3, lo cual es ya lo mas común en una instalación de Linux.

Instalar acme-cerbot

Una vez instalado necesitamos descargar el script de phyton que nos permitirá trabajar con este tipo de desafío, o validación mediante DNS.

Antes descargar nada, es buena práctica revisar el repositorio desde el que vamos a descargar el script. Antiguamente, no había forma salvo que conocieras un poco el programa y los sistemas implicados. Hoy día puedes usar si no alcanzas a esto, una chat de IA para que te verifique el scripts y te lo explique, como si fueras un novato en sistemas Linux y Python.

wget https://github.com/joohoi/acme-dns-certbot-joohoi/raw/master/acme-dns-auth.py

Lo hacemos ejecutable

chmod +x acme-dns-auth.py

Lo editamos para decirle que use Python 3

nano acme-dns-auth.py

#!/usr/bin/env python3

...

Una vez que hallamos realizado el cambio, movemos el fichero

sudo mv acme-dns-auth.py /etc/letsencrypt/

Configurar y usar acem-dns-cerbot

La cuestión es hora simple

sudo certbot certonly --manual --manual-auth-hook /etc/letsencrypt/acme-dns-auth.py --preferred-challenges dns --debug-challenges -d \*.tu-dominio -d tu-dominio

Eso es una idea, basándonos en que tienes un * en tu zona dns. Pero puedes dejarlo en la simpleza del dominio normal, el que contiene www y otros como mail, etc. Pero el consejo es que todos resuelvan a la ip

Ejemplo ficticio que surge de tener todo lo que te pida respecto de la zona DNS del dominio solicitado.

Antes de darle a continuar Press Enter to Continue es evidente que ya has creado el registro en la zona del dominio, tal y como te solicitan, o de lo contrario fallará la generación del certificado Let's Encrypt.

certbot certonly --manual --manual-auth-hook /etc/letsencrypt/acme-dns-auth.py --preferred-challenges dns --debug-challenges -d nodo1.midominio.tld

Saving debug log to /var/log/letsencrypt/letsencrypt.log

Requesting a certificate for nodo1.midominio.tld

Hook '--manual-auth-hook' for nodo1.midominio.tld ran with output:

Please add the following CNAME record to your main DNS zone:

_acme-challenge.nodo1.midominio.tld CNAME cc94069f-6419-4c31-b079-d4408ec2bac6.auth.acme-dns.io.

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

Challenges loaded. Press continue to submit to CA.

Pass "-v" for more info about challenges.

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

Press Enter to Continue

Successfully received certificate.

Certificate is saved at: /etc/letsencrypt/live/nodo1.midominio.tld/fullchain.pem

Key is saved at: /etc/letsencrypt/live/nodo1.midominio.tld/privkey.pem

This certificate expires on 2025-08-11.

These files will be updated when the certificate renews.

Certbot has set up a scheduled task to automatically renew this certificate in the background.

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

If you like Certbot, please consider supporting our work by:

* Donating to ISRG / Let's Encrypt: https://letsencrypt.org/donate

* Donating to EFF: https://eff.org/donate-le

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

Con esto ya puedes configurar el sitio de manera temporal, hasta que resuelva en la maquina. Después lo suyo seria revocarlo y comenzar un proceso normal, basado en web.

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

Cambio de hostname permanentemente

Introducción

Algunas veces nos equivocamos, no teníamos el hostname definitivo o bien hemos instalado un VPS desde una plantilla, y necesitamos cambiar de forma permanente el hostname.

El fichero habitual que controla el hostname habitualmente es /etc/hostname pero puedo y suele, haber más ficheros implicados

Conocer el hostname en el shell

Aquí tenemos el comando hostnamectl para ver los datos

# hostnamectl

Static hostname: template2004

Icon name: computer-vm

Chassis: vm

Machine ID: 1169e389ab834b238027f744b7cf1ae6

Boot ID: e47b8b52d7fe46bf9659f9758d475a73

Virtualization: kvm

Operating System: Ubuntu 20.04.2 LTS

Kernel: Linux 5.4.0-73-generic

Architecture: x86-64

Y también podemos ver el propio fichero

# cat /etc/hostname

template2004

Cambiar el hostname permanentemente en Ubuntu 20.04 LTS

Ejecutar hostname con opciones

sudo hostnamectl set-hostname newNameHere

Editar el fichero /etc/hosts reemplazando cualquier concurrencia del viejo nombre.

También podemos utilizar sed pero quizás sea mejor hacerlo manualmente con nuestro editor favorito.

sed -i -e ‘s/viejo_nombre/nuevo_nombre/g’ /etc/hosts

Cambiar el hostname sin reiniciar en Ubuntu 20.04 LTS

El procedimiento anterior es válido. Lo unico es que en el terminal seguiremos viendo el nombre antiguo en lugar del actual que podemos verificar con

# hostnamectl

Static hostname: kvm300

Icon name: computer-vm

Chassis: vm

Machine ID: 1169e389ab834b238027f744b7cf1ae6

Boot ID: e47b8b52d7fe46bf9659f9758d475a73

Virtualization: kvm

Operating System: Ubuntu 20.04.2 LTS

Kernel: Linux 5.4.0-73-generic

Architecture: x86-64

Para ver el cambio en el indicador del terminal, debemos salir de nuestra shell o hacer un reload de nuestro intérprete de comandos.

Otros ficheros

Si tenemos instalado Postfix u otros demonios que requieren el uso de su propia variable o línea con el nombre del host, puede ser interesante ejecutar el comando de abajo para ver si existe algún otro fichero que debemos corregir.

# find /etc/ -type f -exec grep -il 'template2004' {} \;

/etc/ssh/ssh_host_rsa_key.pub

/etc/ssh/ssh_host_dsa_key.pub

/etc/ssh/ssh_host_ecdsa_key.pub

/etc/ssh/ssh_host_ed25519_key.pub

/etc/postfix/main.cf

/etc/aliases.db

Algunos de ellos, requerirán un reinicio o la aplicación de algún comando para actualizarse.

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

Hardware

El trabajo con el hardware también es necesario y configurable.

Conocer el hardware en linea de comandos (shell)

Comandos para identificar hardware y configuraciones especificas

Hardware

Información procesador

# grep 'vendor_id' /proc/cpuinfo ; grep 'model name' /proc/cpuinfo ; grep 'cpu MHz' /proc/cpuinfo

vendor_id : GenuineIntel

vendor_id : GenuineIntel

vendor_id : GenuineIntel

vendor_id : GenuineIntel

vendor_id : GenuineIntel

vendor_id : GenuineIntel

vendor_id : GenuineIntel

vendor_id : GenuineIntel

vendor_id : GenuineIntel

vendor_id : GenuineIntel

vendor_id : GenuineIntel

vendor_id : GenuineIntel

model name : Intel(R) Xeon(R) E-2136 CPU @ 3.30GHz

model name : Intel(R) Xeon(R) E-2136 CPU @ 3.30GHz

model name : Intel(R) Xeon(R) E-2136 CPU @ 3.30GHz

model name : Intel(R) Xeon(R) E-2136 CPU @ 3.30GHz

model name : Intel(R) Xeon(R) E-2136 CPU @ 3.30GHz

model name : Intel(R) Xeon(R) E-2136 CPU @ 3.30GHz

model name : Intel(R) Xeon(R) E-2136 CPU @ 3.30GHz

model name : Intel(R) Xeon(R) E-2136 CPU @ 3.30GHz

model name : Intel(R) Xeon(R) E-2136 CPU @ 3.30GHz

model name : Intel(R) Xeon(R) E-2136 CPU @ 3.30GHz

model name : Intel(R) Xeon(R) E-2136 CPU @ 3.30GHz

model name : Intel(R) Xeon(R) E-2136 CPU @ 3.30GHz

cpu MHz : 848.767

cpu MHz : 950.482

cpu MHz : 800.024

cpu MHz : 869.512

cpu MHz : 823.590

cpu MHz : 800.024

cpu MHz : 799.822

cpu MHz : 851.184

cpu MHz : 802.642

cpu MHz : 1182.916

cpu MHz : 1121.081

cpu MHz : 802.441

Marca procesador

Si el procesdor es intel el comando de abajo devolvera algo

# grep -i vmx /proc/cpuinfo

Si el procesador es AMD el comnado de abjo devolverá algo

# grep -i svm /proc/cpuinfo

Discos duros

lsblk (info particiones)

lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 3,7T 0 disk

├─sda1 8:1 0 511M 0 part /boot/efi

├─sda2 8:2 0 50G 0 part

│ └─md2 9:2 0 50G 0 raid1 /

├─sda3 8:3 0 511M 0 part [SWAP]

├─sda4 8:4 0 1000G 0 part

│ └─md4 9:4 0 1000G 0 raid1 /var

└─sda5 8:5 0 2,6T 0 part

└─md5 9:5 0 2,6T 0 raid1 /home

sdb 8:16 0 3,7T 0 disk

├─sdb1 8:17 0 511M 0 part

├─sdb2 8:18 0 50G 0 part

│ └─md2 9:2 0 50G 0 raid1 /

├─sdb3 8:19 0 511M 0 part [SWAP]

├─sdb4 8:20 0 1000G 0 part

│ └─md4 9:4 0 1000G 0 raid1 /var

└─sdb5 8:21 0 2,6T 0 part

└─md5 9:5 0 2,6T 0 raid1 /home

loop0 7:0 0 2,2G 0 loop /var/tmp

Discos duros (Atributos)

# blkid

/dev/md4: LABEL="/var" UUID="bfa920a1-48e4-4d4e-ad9a-1f5289ec630e" TYPE="ext4"

/dev/sdb4: UUID="0ceedb71-9478-ba95-a4d2-adc226fd5302" TYPE="linux_raid_member" PARTLABEL="logical" PARTUUID="9ba975e1-1b14-49d3-8971-b936e8d5e4e4"

/dev/sda4: UUID="0ceedb71-9478-ba95-a4d2-adc226fd5302" TYPE="linux_raid_member" PARTLABEL="logical" PARTUUID="66b5b2c5-7be1-49e5-a792-9f87e2f7b4f5"

/dev/sda1: LABEL="EFI_SYSPART" UUID="42B6-5CF2" TYPE="vfat" PARTLABEL="primary" PARTUUID="da4d4fc9-d837-41d9-a107-e742798f9335"

/dev/sda2: UUID="facf2df2-7b51-d62e-a4d2-adc226fd5302" TYPE="linux_raid_member" PARTLABEL="primary" PARTUUID="d9d59890-5495-4d5c-b1a1-9c7cb06ea760"

/dev/sda3: LABEL="swap-sda3" UUID="b3455011-b526-4882-9103-53aea1ba8861" TYPE="swap" PARTLABEL="primary" PARTUUID="b5bd8cbf-6bd4-484d-a66f-95e026322fe3"

/dev/sda5: UUID="8841cb2a-ce20-324b-a4d2-adc226fd5302" TYPE="linux_raid_member" PARTLABEL="logical" PARTUUID="0a0c4007-1aa6-4bbd-8c94-b059e5e47a0e"

/dev/sdb1: LABEL="EFI_SYSPART" UUID="42EC-11F4" TYPE="vfat" PARTLABEL="primary" PARTUUID="96828372-cc5c-4f44-bfc4-0758c394b1bb"

/dev/sdb2: UUID="facf2df2-7b51-d62e-a4d2-adc226fd5302" TYPE="linux_raid_member" PARTLABEL="primary" PARTUUID="ea54dfc3-e5c8-4436-be12-9515d1f1f0f1"

/dev/sdb3: LABEL="swap-sdb3" UUID="7bf2c3e0-e995-4dbf-9edf-de91db5cc4e0" TYPE="swap" PARTLABEL="primary" PARTUUID="0581737a-20c0-44b7-957c-6190b583f1af"

/dev/sdb5: UUID="8841cb2a-ce20-324b-a4d2-adc226fd5302" TYPE="linux_raid_member" PARTLABEL="logical" PARTUUID="c02afe0d-c242-4dd9-8ec7-77ecd90e510b"

/dev/md2: LABEL="/" UUID="424a9e66-51b2-4947-97b2-0d632d79a97f" TYPE="ext4"

/dev/md5: LABEL="/home" UUID="0de14a77-8d9e-4f25-9c1b-bec542d45f22" TYPE="ext4"

/dev/loop0: UUID="8fa0ffb8-aaa1-4321-9d4f-d55a9b021bcc" TYPE="ext3"

Estado solido o mecánico

Devuelve 0 por SSD y 1 por discos mencánicos

cat /sys/block/sda/queue/rotational

Discos NVMe

Necesitamos ewl paquete (Ubuntu) nmve-cli para comprobar discos de tipo NVMe

# nvme list

Node SN Model Namespace Usage Format FW Rev

---------------- -------------------- ---------------------------------------- --------- -------------------------- ---------------- --------

/dev/nvme0n1 S439NE0N101969 SAMSUNG MZQLB1T9HAJR-00007 1 958.95 GB / 1.92 TB 512 B + 0 B EDA5202Q

/dev/nvme1n1 S439NE0N101968 SAMSUNG MZQLB1T9HAJR-00007 1 1.69 TB / 1.92 TB 512 B + 0 B EDA5202Q

Discos duros (hdparam)

El comando hdparm puede que no este instalado en tu distribución.

yum install hdparm -y

# hdparm -I /dev/sda

/dev/sda:

ATA device, with non-removable media

Model Number: HGST HUS726040ALA610

Serial Number: N8GNY2YY

Firmware Revision: A5GNT920

Transport: Serial, ATA8-AST, SATA 1.0a, SATA II Extensions, SATA Rev 2.5, SATA Rev 2.6, SATA Rev 3.0; Revision: ATA8-AST T13 Project D1697 Revision 0b

Standards:

Used: unknown (minor revision code 0x0029)

Supported: 9 8 7 6 5

Likely used: 9

Configuration:

Logical max current

cylinders 16383 16383

heads 16 16

sectors/track 63 63

--

CHS current addressable sectors: 16514064

LBA user addressable sectors: 268435455

LBA48 user addressable sectors: 7814037168

Logical Sector size: 512 bytes

Physical Sector size: 512 bytes

device size with M = 1024*1024: 3815447 MBytes

device size with M = 1000*1000: 4000787 MBytes (4000 GB)

cache/buffer size = unknown

Form Factor: 3.5 inch

Nominal Media Rotation Rate: 7200

Capabilities:

LBA, IORDY(can be disabled)

Queue depth: 32

Standby timer values: spec'd by Standard, no device specific minimum

R/W multiple sector transfer: Max = 16 Current = 16

Advanced power management level: 254

DMA: mdma0 mdma1 mdma2 udma0 udma1 udma2 udma3 udma4 udma5 *udma6

Cycle time: min=120ns recommended=120ns

PIO: pio0 pio1 pio2 pio3 pio4

Cycle time: no flow control=120ns IORDY flow control=120ns

Commands/features:

Enabled Supported:

* SMART feature set

Security Mode feature set

* Power Management feature set

* Write cache

* Look-ahead

* Host Protected Area feature set

* WRITE_BUFFER command

* READ_BUFFER command

* NOP cmd

* DOWNLOAD_MICROCODE

* Advanced Power Management feature set

Power-Up In Standby feature set

* SET_FEATURES required to spinup after power up

SET_MAX security extension

* 48-bit Address feature set

* Device Configuration Overlay feature set

* Mandatory FLUSH_CACHE

* FLUSH_CACHE_EXT

* SMART error logging

* SMART self-test

* Media Card Pass-Through

* General Purpose Logging feature set

* WRITE_{DMA|MULTIPLE}_FUA_EXT

* 64-bit World wide name

* URG for READ_STREAM[_DMA]_EXT

* URG for WRITE_STREAM[_DMA]_EXT

* WRITE_UNCORRECTABLE_EXT command

* {READ,WRITE}_DMA_EXT_GPL commands

* Segmented DOWNLOAD_MICROCODE

* unknown 119[6]

unknown 119[7]

* Gen1 signaling speed (1.5Gb/s)

* Gen2 signaling speed (3.0Gb/s)

* Gen3 signaling speed (6.0Gb/s)

* Native Command Queueing (NCQ)

* Host-initiated interface power management

* Phy event counters

* NCQ priority information

* unknown 76[15]

Non-Zero buffer offsets in DMA Setup FIS

* DMA Setup Auto-Activate optimization

Device-initiated interface power management

In-order data delivery

* Software settings preservation

unknown 78[7]

unknown 78[10]

unknown 78[11]

* SMART Command Transport (SCT) feature set

* SCT Write Same (AC2)

* SCT Error Recovery Control (AC3)

* SCT Features Control (AC4)

* SCT Data Tables (AC5)

* reserved 69[3]

* reserved 69[4]

* WRITE BUFFER DMA command

* READ BUFFER DMA command

Security:

Master password revision code = 65534

supported

not enabled

not locked

not frozen

not expired: security count

not supported: enhanced erase

Logical Unit WWN Device Identifier: 5000cca244c984a4

NAA : 5

IEEE OUI : 000cca

Unique ID : 244c984a4

Checksum: correct

lshw

lshw -class disk -class storage

*-sata

description: SATA controller

product: Cannon Lake PCH SATA AHCI Controller

vendor: Intel Corporation

physical id: 17

bus info: pci@0000:00:17.0

logical name: scsi0

logical name: scsi1

version: 10

width: 32 bits

clock: 66MHz

capabilities: sata msi pm ahci_1.0 bus_master cap_list emulated

configuration: driver=ahci latency=0

resources: irq:125 memory:91200000-91201fff memory:91203000-912030ff ioport:4050(size=8) ioport:4040(size=4) ioport:4020(size=32) memory:91202000-912027ff

*-disk:0

description: ATA Disk

product: HGST HUS726040AL

physical id: 0

bus info: scsi@0:0.0.0

logical name: /dev/sda

version: T920

serial: N8GNY2YY

size: 3726GiB (4TB)

capabilities: gpt-1.00 partitioned partitioned:gpt

configuration: ansiversion=5 guid=9aa4231a-644b-40c9-9105-0e980dbeeeaa logicalsectorsize=512 sectorsize=512

*-disk:1

description: ATA Disk

product: HGST HUS726040AL

physical id: 1

bus info: scsi@1:0.0.0

logical name: /dev/sdb

version: T920

serial: K4KRJ0KB

size: 3726GiB (4TB)

capabilities: gpt-1.00 partitioned partitioned:gpt

configuration: ansiversion=5 guid=2c1a29d1-8bb6-4d02-9990-b9f2fb7b3414 logicalsectorsize=512 sectorsize=512

# lshw -short -C disk

H/W path Device Class Description

====================================================

/0/100/17/0 /dev/sda disk 4TB HGST HUS726040AL

/0/100/17/1 /dev/sdb disk 4TB HGST HUS726040AL

smartctl

Importante para ver el estado de tus discos. Sobre todo cuando compras o alquilas hardware

smartctl -d ata -a -i /dev/sda

smartctl 7.0 2018-12-30 r4883 [x86_64-linux-3.10.0-962.3.2.lve1.5.49.el7.x86_64] (local build)

Copyright (C) 2002-18, Bruce Allen, Christian Franke, www.smartmontools.org

=== START OF INFORMATION SECTION ===

Model Family: HGST Ultrastar 7K6000

Device Model: HGST HUS726040ALA610

Serial Number: N8GNY2YY

LU WWN Device Id: 5 000cca 244c984a4

Firmware Version: A5GNT920

User Capacity: 4.000.787.030.016 bytes [4,00 TB]

Sector Size: 512 bytes logical/physical

Rotation Rate: 7200 rpm

Form Factor: 3.5 inches

Device is: In smartctl database [for details use: -P show]

ATA Version is: ACS-2, ATA8-ACS T13/1699-D revision 4

SATA Version is: SATA 3.1, 6.0 Gb/s (current: 6.0 Gb/s)

Local Time is: Sun May 16 17:57:14 2021 CEST

SMART support is: Available - device has SMART capability.

SMART support is: Enabled

=== START OF READ SMART DATA SECTION ===

SMART overall-health self-assessment test result: PASSED

General SMART Values:

Offline data collection status: (0x84) Offline data collection activity

was suspended by an interrupting command from host.

Auto Offline Data Collection: Enabled.

Self-test execution status: ( 0) The previous self-test routine completed

without error or no self-test has ever

been run.

Total time to complete Offline

data collection: ( 113) seconds.

Offline data collection

capabilities: (0x5b) SMART execute Offline immediate.

Auto Offline data collection on/off support.

Suspend Offline collection upon new

command.

Offline surface scan supported.

Self-test supported.

No Conveyance Self-test supported.

Selective Self-test supported.

SMART capabilities: (0x0003) Saves SMART data before entering

power-saving mode.

Supports SMART auto save timer.

Error logging capability: (0x01) Error logging supported.

General Purpose Logging supported.

Short self-test routine

recommended polling time: ( 2) minutes.

Extended self-test routine

recommended polling time: ( 571) minutes.

SCT capabilities: (0x003d) SCT Status supported.

SCT Error Recovery Control supported.

SCT Feature Control supported.

SCT Data Table supported.

SMART Attributes Data Structure revision number: 16

Vendor Specific SMART Attributes with Thresholds:

ID# ATTRIBUTE_NAME FLAG VALUE WORST THRESH TYPE UPDATED WHEN_FAILED RAW_VALUE

1 Raw_Read_Error_Rate 0x000b 100 100 016 Pre-fail Always - 0

2 Throughput_Performance 0x0005 135 135 054 Pre-fail Offline - 112

3 Spin_Up_Time 0x0007 184 184 024 Pre-fail Always - 265 (Average 315)

4 Start_Stop_Count 0x0012 100 100 000 Old_age Always - 80

5 Reallocated_Sector_Ct 0x0033 100 100 005 Pre-fail Always - 0

7 Seek_Error_Rate 0x000b 100 100 067 Pre-fail Always - 0

8 Seek_Time_Performance 0x0005 128 128 020 Pre-fail Offline - 18

9 Power_On_Hours 0x0012 097 097 000 Old_age Always - 27686

10 Spin_Retry_Count 0x0013 100 100 060 Pre-fail Always - 0

12 Power_Cycle_Count 0x0032 100 100 000 Old_age Always - 75

192 Power-Off_Retract_Count 0x0032 080 080 000 Old_age Always - 24197

193 Load_Cycle_Count 0x0012 080 080 000 Old_age Always - 24197

194 Temperature_Celsius 0x0002 162 162 000 Old_age Always - 37 (Min/Max 19/52)

196 Reallocated_Event_Count 0x0032 100 100 000 Old_age Always - 0

197 Current_Pending_Sector 0x0022 100 100 000 Old_age Always - 0

198 Offline_Uncorrectable 0x0008 100 100 000 Old_age Offline - 0

199 UDMA_CRC_Error_Count 0x000a 200 200 000 Old_age Always - 0

SMART Error Log Version: 1

No Errors Logged

SMART Self-test log structure revision number 1

Num Test_Description Status Remaining LifeTime(hours) LBA_of_first_error

# 1 Short offline Completed without error 00% 26073 -

# 2 Short offline Completed without error 00% 26058 -

# 3 Short offline Completed without error 00% 26058 -

# 4 Short offline Completed without error 00% 16865 -

# 5 Short offline Completed without error 00% 16850 -

# 6 Short offline Completed without error 00% 16850 -

# 7 Short offline Completed without error 00% 15329 -

# 8 Short offline Completed without error 00% 15314 -

# 9 Short offline Completed without error 00% 15314 -

#10 Short offline Completed without error 00% 15288 -

#11 Short offline Completed without error 00% 15278 -

#12 Short offline Completed without error 00% 15264 -

#13 Short offline Completed without error 00% 15264 -

#14 Short offline Completed without error 00% 15249 -

#15 Short offline Completed without error 00% 15249 -

#16 Short offline Completed without error 00% 15099 -

#17 Short offline Completed without error 00% 29 -

#18 Short offline Completed without error 00% 23 -

#19 Short offline Completed without error 00% 23 -

#20 Short offline Completed without error 00% 2 -

SMART Selective self-test log data structure revision number 1

SPAN MIN_LBA MAX_LBA CURRENT_TEST_STATUS

1 0 0 Not_testing

2 0 0 Not_testing

3 0 0 Not_testing

4 0 0 Not_testing

5 0 0 Not_testing

Selective self-test flags (0x0):

After scanning selected spans, do NOT read-scan remainder of disk.

If Selective self-test is pending on power-up, resume after 0 minute delay.

Estado del RAID pro software

cat /proc/mdstat

Personalities : [raid1]

md5 : active raid1 sda5[0] sdb5[1]

2804960192 blocks [2/2] [UU]

bitmap: 12/21 pages [48KB], 65536KB chunk

md4 : active raid1 sdb4[1] sda4[0]

1048573888 blocks [2/2] [UU]

bitmap: 4/8 pages [16KB], 65536KB chunk

md2 : active raid1 sdb2[1] sda2[0]

52427712 blocks [2/2] [UU]

Hardware información general

Hardware información general resumida

# lshw -short

H/W path Device Class Description

====================================================

system To Be Filled By O.E.M. (To Be Filled By O.E.M.)

/0 bus E3C242D4U2-2T

/0/0 memory 64KiB BIOS

/0/9 memory 32GiB System Memory

/0/9/0 memory 16GiB DIMM DDR4 Synchronous 2666 MHz (0,4 ns)

/0/9/1 memory DIMM [empty]

/0/9/2 memory 16GiB DIMM DDR4 Synchronous 2666 MHz (0,4 ns)

/0/9/3 memory DIMM [empty]

/0/14 memory 384KiB L1 cache

/0/15 memory 1536KiB L2 cache

/0/16 memory 12MiB L3 cache

/0/17 processor Intel(R) Xeon(R) E-2136 CPU @ 3.30GHz

/0/100 bridge 8th Gen Core Processor Host Bridge/DRAM Registers

/0/100/8 generic Xeon E3-1200 v5/v6 / E3-1500 v5 / 6th/7th/8th Gen Core Processor Gaussian Mixture Model

/0/100/12 generic Cannon Lake PCH Thermal Controller

/0/100/14 bus Cannon Lake PCH USB 3.1 xHCI Host Controller

/0/100/14/0 usb1 bus xHCI Host Controller

/0/100/14/1 usb2 bus xHCI Host Controller

/0/100/14.2 memory RAM memory

/0/100/15 bus Cannon Lake PCH Serial IO I2C Controller #0

/0/100/15.1 bus Cannon Lake PCH Serial IO I2C Controller #1

/0/100/16 communication Cannon Lake PCH HECI Controller

/0/100/16.4 communication Cannon Lake PCH HECI Controller #2

/0/100/17 scsi0 storage Cannon Lake PCH SATA AHCI Controller

/0/100/17/0 /dev/sda disk 4TB HGST HUS726040AL

/0/100/17/0/1 /dev/sda1 volume 510MiB Windows FAT volume

/0/100/17/0/2 /dev/sda2 volume 49GiB EXT4 volume

/0/100/17/0/3 /dev/sda3 volume 510MiB Linux swap volume

/0/100/17/0/4 /dev/sda4 volume 999GiB EXT4 volume

/0/100/17/0/5 /dev/sda5 volume 2675GiB EXT4 volume

/0/100/17/1 /dev/sdb disk 4TB HGST HUS726040AL

/0/100/17/1/1 /dev/sdb1 volume 510MiB Windows FAT volume

/0/100/17/1/2 /dev/sdb2 volume 49GiB EXT4 volume

/0/100/17/1/3 /dev/sdb3 volume 510MiB Linux swap volume

/0/100/17/1/4 /dev/sdb4 volume 999GiB EXT4 volume

/0/100/17/1/5 /dev/sdb5 volume 2675GiB EXT4 volume

/0/100/1b bridge Cannon Lake PCH PCI Express Root Port #21

/0/100/1b/0 eth0 network Ethernet Controller 10G X550T

/0/100/1b/0.1 eth1 network Ethernet Controller 10G X550T

/0/100/1c bridge Cannon Lake PCH PCI Express Root Port #1

/0/100/1c/0 bridge AST1150 PCI-to-PCI Bridge

/0/100/1c/0/0 display ASPEED Graphics Family

/0/100/1d bridge Cannon Lake PCH PCI Express Root Port #9

/0/100/1e communication Cannon Lake PCH Serial IO UART Host Controller

/0/100/1f bridge Intel Corporation

/0/100/1f.4 bus Cannon Lake PCH SMBus Controller

/0/100/1f.5 bus Cannon Lake PCH SPI Controller

/0/1 system PnP device PNP0c02

/0/2 system PnP device PNP0c02

/0/3 communication PnP device PNP0501

/0/4 communication PnP device PNP0501

/0/5 system PnP device PNP0c02

/0/6 generic PnP device INT3f0d

/0/7 system PnP device PNP0c02

/0/8 system PnP device PNP0c02

/0/a system PnP device PNP0c02

/0/b system PnP device PNP0c02

Hardware información general detallada

# lshw | less

MegaCli

MegaCli es una herramienta especifica de la familia de controladoras LSI MegaRaid

Auqne muchos manuales idtentifican los caomando unas veces en minusculas, otros con alternacia de mayúsculas y minúsculas, lo qmejor es crear un alias, apuntado al que corresponda. Si te falla alguna información en al gun tip, que ves por internet esa es la razón.

En mi caso uso MegaCli ya que hice en su día ln -s /usr/sbin/megacli MegaCli

Conocer el estado de la controladora

root@pro02:~# MegaCli -EncInfo -aALL

Number of enclosures on adapter 0 -- 1

Enclosure 0:

Device ID : 252

Number of Slots : 8

Number of Power Supplies : 0

Number of Fans : 0

Number of Temperature Sensors : 0

Number of Alarms : 0

Number of SIM Modules : 1

Number of Physical Drives : 8

Status : Normal

Position : 1

Connector Name : Unavailable

Enclosure type : SGPIO

FRU Part Number : N/A

Enclosure Serial Number : N/A

ESM Serial Number : N/A

Enclosure Zoning Mode : N/A

Partner Device Id : Unavailable

Inquiry data :

Vendor Identification : AVAGO

Product Identification : SGPIO

Product Revision Level : N/A

Vendor Specific :

Exit Code: 0x00

Sistema

Arquitectura

lshw no tiene porque estar disponible en tu distribucion. Si es asi instalalo o busca alternativa.

# sudo lshw -C CPU | grep width

width: 64 bits

Enlaces y agradecimientos

- How to find out Hard Disk Specks /Deatis on Linux

- Using NVMe Command Line Tools to Check NVMe Flash Health

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

Uso de UUID para montar particiones linux

Introducción

El UUID (Identificador único universal) es un identificador estandarizado usado en el desarrollo del software por la OSF (Open Software Foundation) y es parte del Entorno de Distribución de Software (DCE).

El objetivo del uso del UUID es permitir que los sistemas distribuidos identifiquen de manera única y sin una coordinación central los elementos de hardware y software. Cualquier administrador puede crear un UUID y usarlo para identificar algo con confianza razonable que nadie involuntariamente usará el mismo identificador en otros elemento o dispositivo.

Beneficios del uso de UUID

Su uso es especialmente útil, en un entorno personal, para asignar por ejemplo, el montaje de discos externos o internos, sin temor a que por razones del hardware, la asignación numérica habitual, haga fracasar el montaje de discos, cuando añadimos o eliminamos algún dispositivo nuevo.

Dispositivos, SAN, iSCSI, DAS, volúmenes externos, son los mejores candidatos para el uso de UUID en el fichero fstab.

Comando blkid el sustituto de vol_id

Muchos de los tutoriales se han quedado obsoletos, ya que hacen uso del comando vol_id sustituido por blkid

sudo vol_id --uuid /dev/sdb2

sudo: vol_id: orden no encontrada

En su lugar podemos usar blkid

❯ sudo blkid

/dev/nvme0n1p1: UUID="9047-9E81" TYPE="vfat" PARTUUID="cb856993-8dff-48f8-8646-0a4f333d2e7a"

/dev/nvme0n1p2: UUID="dcV8h8-Ie6y-9yey-5RUE-YfPP-E0ra-fZAXSy" TYPE="LVM2_member" PARTUUID="d7a787ab-2143-46c5-b2aa-e46941a9210d"

/dev/sda1: UUID="8aa6c0d2-c18e-4606-b1da-f5f1f7617f00" TYPE="xfs" PARTLABEL="backup3t" PARTUUID="f6b13129-366f-4d3c-8b79-05514ebcaff5"

/dev/sdb1: LABEL="ssd" UUID="297ddd6c-f224-4385-8f89-e44f4a6912f3" TYPE="ext4" PARTUUID="57b4c3da-5bde-4a2f-83d5-fa43c13b63cb"

/dev/mapper/kubuntu--vg-root: UUID="3c55b16d-1ad7-4ced-a552-874cc97ba0d3" TYPE="ext4"

/dev/mapper/kubuntu--vg-swap_1: UUID="f6655751-5635-4acb-9ba6-5d3530aace9d" TYPE="swap

❯ sudo blkid /dev/nvme0n1p1

/dev/nvme0n1p1: UUID="9047-9E81" TYPE="vfat" PARTUUID="cb856993-8dff-48f8-8646-0a4f333d2e7a"

❯ sudo blkid /dev/sda1

/dev/sda1: UUID="8aa6c0d2-c18e-4606-b1da-f5f1f7617f00" TYPE="xfs" PARTLABEL="backup3t" PARTUUID="f6b13129-366f-4d3c-8b79-05514ebcaff5"

Uso de UUID en el fichero /etc/fstab

Sintaxis

UUID={YOUR-UID} {/path/to/mount/point} {file-system-type} defaults,errors=remount-ro 0 1

Ejemplo para discos XFS

Editamos el fichero /etc/fstab para que contenga el punto de montaje

❯ sudo cat /etc/fstab | grep 8aa6

UUID=8aa6c0d2-c18e-4606-b1da-f5f1f7617f00 /backups xfs rw,noquota,nofail 0 1

Comprobar

❯ sudo mount -a

❯ df -h |grep backups

/dev/sda1 2,8T 1,2T 1,6T 43% /backups

Yo uso habitualmente XFS ya que estoy más especializado en sistemas de backup y correo, donde el número de ficheros es mucho más elevado que otros, por lo que el uso de inodos es importante. XFS me permite un mayor control y calidad que ext4 para este tipo de sistemas. Por eso necesito usar

noquota,nofailen lugar de la sintaxis común de ext4

Enlaces

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

Instalación GPT con el instalador Centos 7 en discos < 2 TiB

Introducción

Uno de los problemas comunes en la generación de templates e incluso en algunas instalaciones, es el uso del obsoleto MBR.

MBR es anticuado, y además presenta problemas en el caso de que en entornos virtuales, tengamos que hacer una ampliación de disco mayor de 2TiB. La eficiacia de GPT es muy superior y recomendable.

Además si algun día nuestro disco quiere crecer por encima de los 2 TiB, ya no lo podrá hacer con MBR.

Anaconda que es el sistema de Centos 7 para particionar el disco, hará lo siguiente:

- Si el disco ya está formateado, respetará el esquema de partición.

- Si el disco tiene más de 2 32 sectores (2 Tib) usará GPT

- Si el disco es de menor tamaño usará MBR.

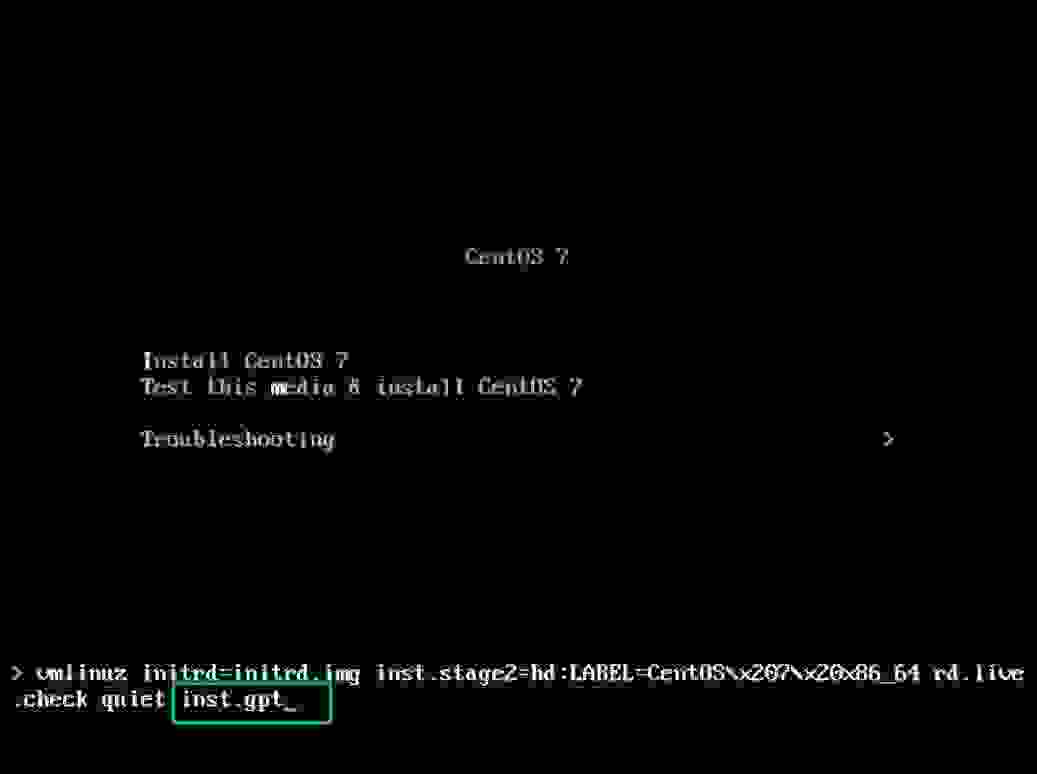

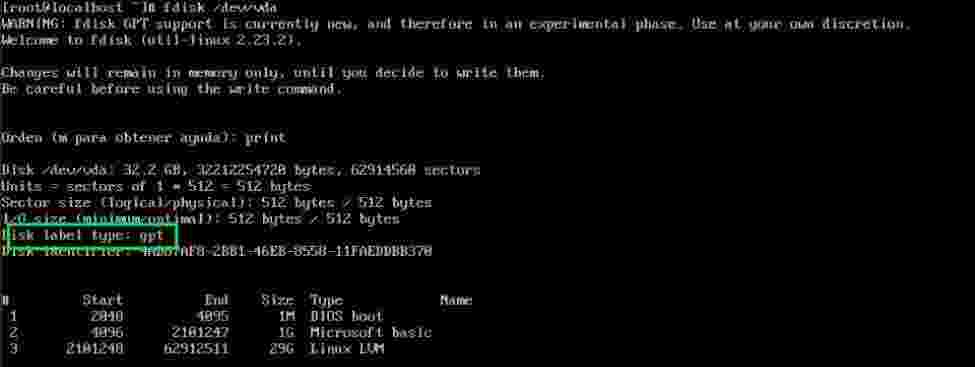

Instalar Centos 7 con tabla de particiones GPT

Aviso

Si bien existen algunos artículos sobre cómo convertir una partición con esquema MBR a GPT, esto no es recomendable, ya que GPT sólo es válido en sistemas compatibles con UEFI, y por tanto requiere una partición EFI /boot/efi de al menos 50 MiB (recomendado 200 MiB) y aunque podemos hacerlo mejor comenzar bien desde el principio.

Discos menores de 2TiB

Al mostrarse el instalador, debemos pulsar Tab para poder añadir a la linea de arranque inst.gpt lo cual de forma silenciosa, hará que anaconda realice la instalación usando el esquema de particiones GPT.

Una vez finalizada la instalación tu disco tendrá un esquema de particiones GPT, que podrás ampliar sin problema mas allá de los 2 TiB

Enlaces

- CentOs - Installation Destination

- [Anaconda](https://es.wikipedia.org/wiki/Anaconda_(instalador)

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

Parted mejor que fdisk

Introducción

Además de que fdisk no puede particionar creando particiones mayores de 2TB, es mucho mejor amigo del sysadmin parted.

En este artículo dejo escrito el cómo hacerlo en el caso de discos que uso en montajes de Proxmox con OVH.

Parted : Creando particiones

Label si esta no existe

Si no existe etiqueta del formato de disco es necesaria así que la creamos

# parted -s /dev/nvme1n1 mklabel gpt

Hacer la partición disponible al 100%

Cómo uso los discos para LVM es necesario crear una partición al 100% Recomendación LVM Howto

# parted -s /dev/nvme1n1 mkpart primary 0% 100%

# parted /dev/nvme1n1

GNU Parted 3.4

Using /dev/nvme1n1

Welcome to GNU Parted! Type 'help' to view a list of commands.

(parted) print

Model: SAMSUNG MZVL2512HCJQ-00B07 (nvme)

Disk /dev/nvme1n1: 512GB

Sector size (logical/physical): 512B/512B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name Flags

1 1049kB 512GB 512GB primary

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

Directadmin

Un panel como otro cualquiera.

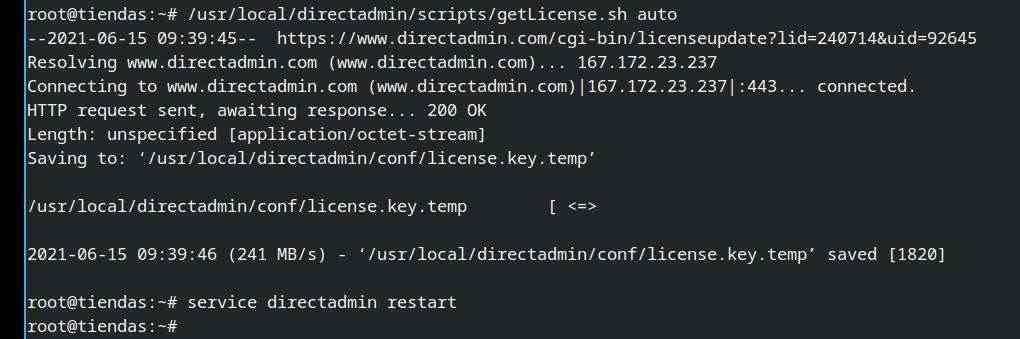

Actualizar la licencia DirectAdmin en el shell

Introducción

Tratamos de entrar en nuestro servidor con DirectAdmin como administradores y nos encontramos con el problema de que no funciona y la licencia esta expirada, o la habiamos renovado o comprado, pero no esta actualizada. No hay problema, acudamos al shell.

Actualziación de la licencia DirectAdmin en shell

Automático

Accedemos a nuestro servidor via ssh y ejecutamos los dos comandos:

- Uno para descargar la licencia

- Otro para reiniciar DirectAdmin

~# /usr/local/directadmin/scripts/getLicense.sh auto

--2021-06-15 09:39:45-- https://www.directadmin.com/cgi-bin/licenseupdate?lid=240714&uid=92645

Resolving www.directadmin.com (www.directadmin.com)... 167.172.23.237

Connecting to www.directadmin.com (www.directadmin.com)|167.172.23.237|:443... connected.

HTTP request sent, awaiting response... 200 OK

Length: unspecified [application/octet-stream]

Saving to: ‘/usr/local/directadmin/conf/license.key.temp’

/usr/local/directadmin/conf/license.key.temp [ <=> ] 1.78K --.-KB/s in 0s

2021-06-15 09:39:46 (241 MB/s) - ‘/usr/local/directadmin/conf/license.key.temp’ saved [1820]

root@tiendas:~# service directadmin restart

Enlace esxterno oficial con otras alternativas

Updating your DirectAdmin License manually

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

MySQL - MariaDb

Un mundo difícil, en el que las diferencias entre los motores SQL del tipo MySQL, comienzan a ser muy problemáticas. Incluso entre las versiones del mismo motor.

ERROR 1118 (42000) at line XXXXX: Row size too large (> 8126)

Introducción

Los upgrades de versión han sido un problema desde MySQL 5 y en MariaDB desde la 10. Muchas veces se quedan flecos que producen errores, que en caso de recuperación de desastres pueden ser un serio handicap.

Error

[root@servidor02b mysql]# bunzip2 < dbdump.db.bz2 | mysql

ERROR 1118 (42000) at line 13300: Row size too large (> 8126). Changing some columns to TEXT or BLOB may help. In current row format, BLOB prefix of 0 bytes is stored inline.

[root@servidor02b mysql]# bunzip2 < dbdump.db.bz2 | mysql

Solución

Editamos el fichero de configuración de mysql (generalmente /etc/my.cnf o dentro de /etc/mysql/) para añadir en la sección [mysqld] el siguiente contenido (puedes adaptarlo a tu sistema, necesidades o posibilidades)

[mysqld]

innodb_log_file_size=512M

innodb_strict_mode=0

Después realizamos un restart del servidor e intentamos de nuevo el restore.

Enlaces

- Troubleshooting Row Size Too Large Errors with InnoDB

- Row size too large (> 8126). Changing some columns to TEXT or BLOB may help. In current row format, BLOB prefix of 0 bytes is stored inline

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

Errores con MariaDB 10.3 al restaurar o hacer backups arrastrando versiones antiguas

Introducción

Los síntomas son variados, pero afectan todos a la base de datos sys la cual existía con anterioridad a la versión 10.3 de MariaDB y que ya está en desuso.

mysqldump: Got error: 1356: "View 'sys.host_summary' references invalid table(s) or column(s) or function(s) or definer/invoker of view lack rights to use them" when using LOCK TABLES

Base de datos sys

Esta base de datos, no se incluye desde la 10.3, pero ha sido incorporada en la versión 10.6.0 (Alpha) y 10.6.1 (Beta), bundle sys schema - MDEV-9077, y si no la usas (probablemente) es seguro eliminarla.

$ mysql

mysql > DROP DATABASE sys;

Si la necesitas, deberás intentar resolver los problemas descritos en los mensajes de error.

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

Como extraer de un backup de MySQL completo una base de datos y/o una tabla

Introducción

Lo habitual en sistemas es tener un backup de bases de datos, por database o esquema. Pero a veces, sólo tenemos un backup completo. Mucho menos habitual es tener backups por tablas, así que en esta entrada, te explicamos cómo obtener el backup de una base de datos obtenida de un backup completo de mysqldump, y/o como extraer una tabla de un backup completo o de un esquema de la base de datos.

Mysql --one-database

Una opción muy potente, que puede ser muy útil en ciertos escenarios (trabajo con logs binarios) pero que requiere un conocimiento profundo de MySQL. Así que mejor ir a lo práctico.

Filtrar el fichero mysqldump con sed

Para mi es la mejor opción para extraer una base de datos o una tabla de un fichero SQL de mysqldump.

$ sed -n '/^-- Current Database: `nombre_de_la_base_de_datos`/,/^-- Current Database: `/p' nombre_del_backup.sql > nombre_de_la_base_de_datos.sql

Tip sed. Pasar una variable a un comando sed

El mismo comando se puede pasar de forma más fácil, usando variables. En mi caso uso este tip, aunque existen otras fórmulas para pasar variables, en este caso muchas de ellas fallaran por las comillas simples invertidas.

$ bd=nombre_de_la_bd

$ mydump=nombre_del_fichero_dump_sql

$ sed -n '/^-- Current Database: `'"${bd}"'`/,/^-- Current Database: `/p' $mydump > ${bd}.sql

Extraer una tabla de un fichero mysqldump

¿Necesitas restaurar una sóla tabla? Sencillo. Cambiamos un poco la estructura de la consulta (trabajando sobre el fichero de una sola base de datos

$ tabla=nombre_de_la_tabla

$ sed -n '/^-- Table structure for table `'"${tabla}"'`/,/^-- Table structure for table /p' ${bd}.sql > ${tabla}.sql

Nota de actualización para MacOs 2024/11/23

Algunas veces a sed en macos le da por mostrar problemas derivados la codificación. (Eso de no ser POSIX al MacosX le mata a veces)

La solución (no lo intentes con las IA que a todas se les va la pinza...)

sed -i -n '/^-- Current Database: `'"${bd}"'`/,/^-- Current Database: `/p' $mydump > ${bd}.sql

sed: RE error: illegal byte sequence

Solución

LC_ALL=C sed -i -n '/^-- Current Database: `'"${bd}"'`/,/^-- Current Database: `/p' $mydump > ${bd}.sql

Renombrar el backup de la tabla extraída para usarlo en la misma base de datos

Atención porque si queremos usar ese backup para crear una copia clonada de la tabla con otro nombre hay que modificar el fichero, ya que de lo contrario volcaremos el contenido en la misma tabla, y si es un backup antiguo, el lío esta servido.

-- Table structure for table `nombre_de_la_tabla`

DROP TABLE IF EXISTS `nombre_de_la_tabla`;

CREATE TABLE `nombre_de_la_tabla` (

-- Dumping data for table `nombre_de_la_tabla`

LOCK TABLES `nombre_de_la_tabla` WRITE;

/*!40000 ALTER TABLE `nombre_de_la_tabla` DISABLE KEYS */;

Asi que debemos cambiarlo. Y una manía muy preocupante es la de usar editores de texto, sobre todo en windows, lo cual puede ser terrorífico, aparte de poco efectivo.

Usaremos sed otra vez.

# newtabla=nueva_tabla

# sed -i -e 's/'"${tabla}"'/'"${newtabla}"'/g' ${tabla}.sql

Enlaces

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

Como crear un usuario Mysql/MariaDB con Grant Privileges

Introducción

La organización es muy adecuada en nuestro trabajo. Crear usuarios y bases de datos sin control alguno, y sin una nomenclatura es signo de desorganización, y el camino previo para las dificultades cuando necesitemos escalar nuestro proyecto. Además, a veces, no podemos dar permiso para todo (root) a todos. Eso sería un grave error en nuestra política de seguridad.

El siguiente artículo, ha sido creado con MariaDb 10.6 pero con algunas diferencias sutiles que podréis encontrar en la documentación de los respectivos motores y versiones.

Permite crear un usuario con privilegios suficientes para crear una base de datos y tener privilegios globales para es base de datos, siempre que cumpla, la nomenclatura de nombres basado en prefijo_

Crear una Database

Si no tienes una base de datos creada, tendrás que crearla.

Los comandos de este documento presuponen que tienes conocimientos básicos de MySQL.

# mysql

Welcome to the MariaDB monitor. Commands end with ; or \g.

Your MariaDB connection id is 49

Server version: 10.6.3-MariaDB-1:10.6.3+maria~focal-log mariadb.org binary distribution

Copyright (c) 2000, 2018, Oracle, MariaDB Corporation Ab and others.

Type 'help;' or '\h' for help. Type '\c' to clear the current input statement.

MariaDB [(none)]> CREATE DATABASE mibasedatos_pre;

Query OK, 1 row affected (0.000 sec)

MariaDB [(none)]> SHOW DATABASES;

+--------------------+

| Database |

+--------------------+

| information_schema |

| mysql |

| performance_schema |

| sys |

| mibasedatos_pre |

+--------------------+

6 rows in set (0.000 sec)

El comando accede como root porque lo tengo configurado a tal fin siendo root. Pude ser que en tu sistema tengas que usar `mysql -u root -p`

Crear un usuario nuevo de MariaDB

MariaDB [(none)]> CREATE USER 'mibasedatos_usr'@'localhost' IDENTIFIED BY 'UnACoNtRaSeñaAdECuADa';

Query OK, 0 rows affected (0.001 sec)

Comprobamos

MariaDB [(none)]> SELECT User FROM mysql.user;

+--------------+

| User |

+--------------+

| mariadb.sys |

| mysql |

| root |

| mibasedatos_pre |

+--------------+

4 rows in set (0.001 sec)

Otorgamos privilegios al user de MariaDB

GRANT CREATE USER, CREATE ON *.* TO 'mibasedatos_usr'@'localhost' IDENTIFIED BY 'CKWor4Jh9CC4UskUg';

MariaDB [(none)]> GRANT ALL PRIVILEGES ON `mibasedatos\_%`.* TO 'mibasedatos_usr'@'localhost' WITH GRANT OPTION;

Query OK, 0 rows affected (0.001 sec)

Otorgamos privilegios al user en MySQL 8 +

CREATE USER, CREATE ON *.* TO 'mibasedatos_usr'@'localhost' IDENTIFIED BY 'CKWor4Jh9CC4UskUg';

GRANT ALL PRIVILEGES ON *.* TO 'myroot'@'localhost';

Comprobación

MariaDB [(none)]> USE mibasedatos_pre;

Database changed

MariaDB [mibasedatos_pre]> CREATE TABLE test (id INT);

Query OK, 0 rows affected (0.003 sec)

Esto permite al usuario **crear cualquier base de datos** pero solo **usar aquellas que comienzan por el prefijo** Si deseas algo más especifico en mi opinión, necesitas hacer un script que genere el usuario y los permisos sucesivos cuando cree una tabla, forzando al uso dle prefijo (estilo cpanel)

Enlaces

- How to Create MariaDB User and Grant Privileges

- MySQL granting privileges on wildcard database name to new user

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

Restaurar mysqldump completo con problemas relacionados con VIEW y sus permisos

Mysqldump, restore, vistas y seguridad

Algunas veces, sobre todo cuando estamos trabajando con backups de otros servidores mysql, con problemas para restaurar un backup de una base de datos individual, que se hizo de forma completa.

Esta incluye las vistas, y por ende, los usuarios con permisos para las vistas, conocido en MySQL como SQL SECURITY DEFINER .

Si en nuestro sistema no existen esos usuarios, a los que hace referencia el fichero sql, obtendremos un fallo, en el volcado o restauración de la copia de seguridad, incluso si lo ejecutamos como root

Por ejemplo

ERROR 1356 (HY000) at line 1693: View 'database.view_condition_xx_table' references invalid table(s) or column(s) or function(s) or definer/invoker of view lack rights to use them

Podemos intentar algunos tips, que hay por ahí, incluso hacer un restore forzado pero nos quedaríamos con la duda de si está todo bien.

Solución propuesta: desactivar al usuario afectado en su SQL SECURITY DEFINER

Primero para ver el tema y si este es el problema realmente (copiar y pegar artículos de internet no es buena idea si no se sabe lo que se hace) vamos a ver si los tiros van por ahí.

❯ cat my-database-dump.sql | grep -i DEFINER

/*!50013 DEFINER=`root`@`127.0.0.1` SQL SECURITY DEFINER */

/*!50013 DEFINER=`root`@`127.0.0.1` SQL SECURITY DEFINER */

/*!50013 DEFINER=`otrouser`@`%` SQL SECURITY DEFINER */

Vemos que existe un usuario que no existe en nuestro servidor, y ese el portanto el que produce el problema en el volcado.

La mejor opción en mi opinión, no es tratar de saltarse o modificar nada en el servidor, sino de obviar ese usuario, salvo que sea de interés crearlo en nuestro sistema, por otras causas.

Desactivación del SQL SECURITY DEFINER problemático

Usando sed podremos cambiar el definer que nos falla a root y volver a intentar la restauración de la copia de seguridad de mysql que nos falló a causa definer/invoker of view lack rights to use them

sed -i.bak 's/DEFINER\=\`otrouser/DEFINER\=\`root/g' my-database-dump.sql

Aviso

Esta documentación y su contenido, no implica que funcione en tu caso o determinados casos. También implica que tienes conocimientos sobre lo que trata, y que en cualquier caso tienes copias de seguridad. El contenido el contenido se entrega, tal y como está, sin que ello implique ningún obligación ni responsabilidad por parte de Castris

Si necesitas soporte profesional puedes contratar con Castris soporte profesional.

Desactivación de las reglas de modos SQL de un sevidor MySQL/MariaDB/Percona

Introducción

Hay una gran diferencia entre usar la desactivación de los modos SQL de un servidor SQL, por necesidad imperiosa, y otra muy distnta de persistir en la creencia de que es lo correcto.

Muchos de los modos SQL, cambia a lo largo de las vidas útiles de una versión de un sistemas de bases de datos, tipo SQL, y esto hace que en el momento más crucial ese cambio:

- Haga inservible, al menos rápidamente, un backup en un escenario de recuperación de desastres.

- No sepueda realziar una migración a un nuevo sistema por incompatibilidad de los datos contenidos.

- Por el fin de soporte de ese workaround que ha sido elminado de la ecuación en la versión nueva.

Consideraciones al Usar sql_mode="":

- Desactivación de Validaciones: Al establecer sql_mode="", se desactivan validaciones como:

-

STRICT_TRANS_TABLES: Permite que las inserciones y actualizaciones que no cumplen con los requisitos de tipo y tamaño se realicen, lo que potencialmente puede llevar a la corrupción de datos. - NO_ZERO_DATE: Previene la inserción de fechas nulas o cero que suelen considerarse inválidas.

- ONLY_FULL_GROUP_BY: Asegura que las consultas que usan GROUP BY cumplan con las reglas estándar SQL.

- Compatibilidad con PHP: Si estás trabajando con PHP y experimentas problemas con la inserción de datos, a veces desactivar modos restrictivos puede solucionar problemas. Sin embargo, esto puede llevar a que se introduzcan datos erróneos o inconsistencia. Es importante identificar por qué los datos no se estaban insertando correctamente en primer lugar.

- Prácticas Recomendadas: En lugar de desactivar todos los modos, es una buena práctica intentar configurar el sql_mode de manera más específica. Por ejemplo, podrías excluir ciertos modos según sea necesario, en lugar de dejarlo vacío completamente:

sql_mode="STRICT_TRANS_TABLES,NO_ZERO_DATE"

## Configuración en my.cnf

Para configurar esto en el archivo my.cnf, puedes agregar o modificar la línea en la sección [mysqld]:

[mysqld]

sql_mode=""

Reiniciar el Servidor

Después de realizar cambios en my.cnf, asegúrate de reiniciar el servidor de MySQL o MariaDB para que los cambios surtan efecto.

systemctl restart mariadb

Comprobación

Acceso a MySQL shell.

MariaDB [(none)]> SHOW VARIABLES LIKE 'sql_mode';

+---------------+-------+

| Variable_name | Value |